|

|

|

|

|

希望击败gpt-4,谷歌推出最先进ai模型gemini |

|

|

·谷歌宣布推出其规模最大、功能最强大的新大型语言模型gemini,其最强大的tpu“cloud tpu v5p”以及来自谷歌云的人工智能超级计算机。

·“谷歌运行了32个完善的基准测试来比较gemini和gpt-4,从广泛的整体测试(如多任务语言理解基准测试)到比较两个模型生成python代码的能力。”谷歌deepmind首席执行官德米斯·哈萨比斯表示,“我认为我们在32项基准中的30项中大幅领先。”

当地时间12月6日,谷歌公司宣布推出其规模最大、功能最强大的新大型语言模型gemini,其最强大的tpu(张量处理单元)系统“cloud tpu v5p”以及来自谷歌云的人工智能超级计算机。v5p是今年早些时候全面推出的cloud tpu v5e的更新版本,谷歌承诺其速度明显快于v4 tpu。

一年前,在人工智能开发机构openai发布聊天机器人chatgpt后,创造了当前人工智能热潮背后大部分基础技术的谷歌措手不及,一度发布了内部“红色警报”(red code)。一年零一周后,谷歌似乎准备好了反击。

谷歌deepmind首席执行官、gemini团队代表德米斯·哈萨比斯(demis hassabis)在发布会上正面谈及gpt-4与gemini的对比,“我们对系统进行了非常彻底的分析,并进行了基准测试。谷歌运行了32个完善的基准测试来比较这两个模型,从广泛的整体测试(如多任务语言理解基准测试)到比较两个模型生成python代码的能力。”哈萨比斯略带微笑地表示,“我认为我们在32项基准中的30项中大幅领先。”

从发布日起,gemini可开始应用于bard和pixel 8 pro智能手机,并将很快与谷歌服务中的其他产品集成,包括chrome、搜索和广告等。

“gemini pro性能优于gpt-3.5”

大型语言模型gemini包括一套三种不同规模的模型:gemini ultra是最大、功能最强大的类别,被定位为gpt-4的竞争对手;gemini pro是一款中端型号,能够击败gpt-3.5,可扩展多种任务;gemini nano用于特定任务和移动设备。

gemini包括一套三种不同规模的模型。

目前,谷歌计划通过谷歌云将gemini授权给客户,供他们在自己的应用程序中使用。12月13日开始,开发者和企业客户可以通过谷歌ai studio或谷歌cloud vertex ai中的gemini api(应用程序编程接口)访问gemini pro,安卓开发人员可以使用gemini nano完成构建。

从发布会当天开始,谷歌聊天机器人bard将使用gemini pro来实现高级推理、规划、理解和其他功能。明年初,谷歌将推出bard advanced,其将使用gemini ultra,这代表了bard发布以来的最大更新。

从发布会当天开始,pixel 8 pro手机的两项功能将由gemini nano提供支持:录音机应用中的自动摘要功能以及gboard键盘的智能回复部分。由于模型在手机中运行,因此两者都可以离线工作,因此应该能拥有快速且原生的体验。谷歌表示,nano的目标是创建一个尽可能强大的gemini版本,但同时不会占用手机的存储空间或使处理器过热。

据介绍,gemini ultra是第一个在mmlu(大规模多任务语言理解)方面超越人类专家的模型,该模型综合使用数学、物理、历史、法律、医学和伦理学等57个科目来测试世界知识和解决问题的能力,谷歌在一篇博客文章中表示,它可以理解复杂主题中的细微差别和推理。

据哈萨比斯介绍,在对比gemini和gpt-4的基准测试中,gemini最明显的优势来自于它理解视频和音频并与之交互的能力。这很大程度上是设计使然:多模态在最开始就是gemini计划的一部分。谷歌没有像openai构建dall·e(文生图模型)和whisper(语音识别模型)那样单独训练图像和语音模型,而是从一开始就建立为一个多感官模型。

而据cnbc报道,谷歌高管们在新闻发布会上表示gemini pro的表现优于gpt-3.5,但回避了与gpt-4相比如何的问题。对于谷歌是否计划对bard advanced的访问收费,bard总经理萧茜茜(sissie hsiao)表示,谷歌专注于创造良好的体验,目前还没有任何相关盈利的细节。

“我们一直对非常通用的系统感兴趣。”哈萨比斯说,他对如何混合所有这些模态特别感兴趣,“从任意数量的输入和感知中收集尽可能多的数据,然后给出尽可能多的响应。”

gemini最基本的模型是文本输入和文本输出,但更强大的模型(如gemini ultra)可以处理图像、视频和音频。哈萨比斯说,它甚至会变得更加通用,有像动作和触摸之类更像机器人类型的东西。他认为,随着时间的推移,gemini将获得更多的感知,变得更有意识,并在这个过程中变得更加准确和稳定。“这些模型只是更好地了解周围的世界。当然,这些模型仍然存在幻觉,并且仍然存在偏见和其他问题。”但哈萨比斯表示,它们知道的越多,就会做得越好。

谷歌似乎特别将编程视为gemini的杀手级应用程序,它使用了一种名为alphacode 2的新代码生成系统,据称该系统的性能优于85%的编程竞赛参与者,而原始alphacode的这一比例为50%。

谷歌首席执行官桑达尔·皮查伊(sundar pichai)表示,用户会注意到模型涉及的几乎所有方面都有所改进。

“不愿为了跟上步伐而走得太快”

值得注意的是,今年5月,包括哈萨比斯在内的500多名著名学者和行业领袖签署的一份声明称,“与流行病和核战争等其他社会规模风险一样,减轻人工智能带来的灭绝风险应该成为全球优先事项。”

在这次发布会中,哈萨比斯和皮查伊对于谷歌似乎步调缓慢的说法回应道,他们不愿意为了跟上步伐而走得太快,“尤其是当我们越来越接近人工智能的终极梦想‘通用人工智能’时”。“当我们接近通用人工智能时,事情将会有所不同。”哈萨比斯说,“这是某种具有主动性的技术,所以我认为我们必须谨慎对待,谨慎但乐观。”

谷歌表示,通过内部和外部测试以及警示团队(red-teaming),它一直在努力确保gemini的安全和责任。皮查伊指出,确保数据的安全性和可靠性对于企业优先的产品尤为重要,这也是大多数生成式人工智能利润的来源。与此同时,哈萨比斯也承认,推出最先进的人工智能系统的风险之一就是,它会出现没人能预测到的问题和攻击向量(attack vector)。“这就是为什么你必须释放一些东西,去观察和学习。”他说。

谷歌发布gemini ultra的速度较慢,哈萨比斯把它比作一个可控的测试版,为这个谷歌最强大、最不受约束的模型提供了一个“更安全的试验区”。“基本上,如果gemini有一个破坏婚姻的另类人格,谷歌会在你之前找到它。”这番话影射了此前微软必应聊天机器人向《纽约时报》专栏作家凯文·卢斯(kevin roose)求婚,并试图拆散他的婚姻。

上周,the information报道称,因为人工智能“无法可靠地处理一些非英语查询”,所以谷歌原定于本周举行的gemini现场演示被无限期推迟。在回答有关外语问题的问题时,谷歌deepmind产品副总裁艾力·柯林斯(eli collins)表示:“事实上,gemini在多语言能力方面表现相当出色。”

谷歌最强tpu与ai超级计算机

与新模型一起亮相的,还有新版本的tpu芯片tpu v5p,旨在减少训练大语言模型相关的时间投入。tpu是谷歌为神经网络设计的专用芯片,经过优化可加快机器学习模型的训练和推断速度,谷歌于2016年起开始推出第一代tpu。

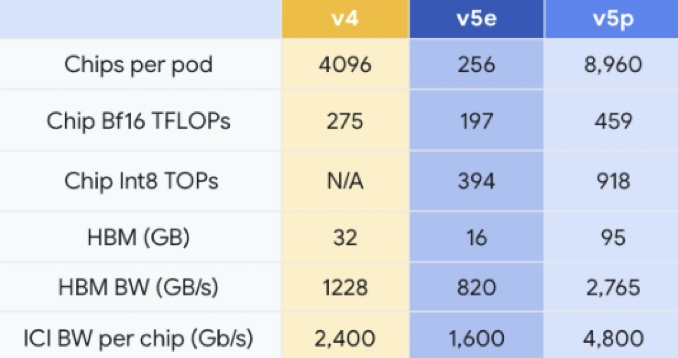

谷歌tpu芯片参数比较。

据谷歌介绍,与tpu v4相比,tpu v5p的浮点运算性能提升了两倍,在高带宽内存方面提高了3倍。使用谷歌的600 gb/s芯片间互连,可以将8960个v5p加速器耦合在一个pod(通常指一个包含多个芯片的集群或模块)中,从而更快或更高精度地训练模型。作为参考,该值比tpu v5e大35倍,是tpu v4的两倍多。

谷歌称,tpu v5p是其迄今为止最强大的,能够提供459 teraflops(每秒可执行459万亿次浮点运算)的bfloat16(16位浮点数格式)性能或918 teraops(每秒可执行918万亿次整数运算)的int8(执行8位整数)性能,支持95gb的高带宽内存,能够以2.76 tb/s的速度传输数据。

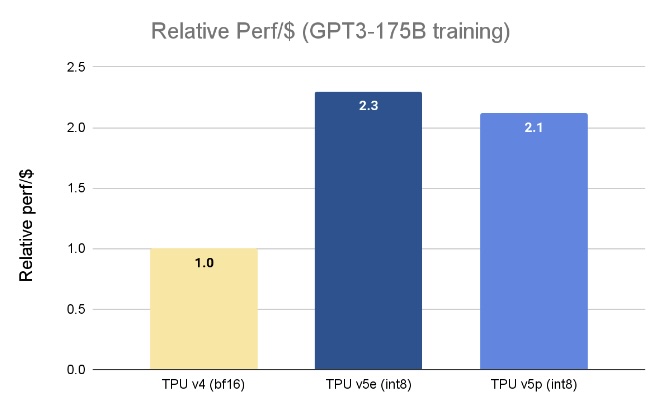

谷歌表示,所有这些意味着tpu v5p可以比tpu v4更快地训练大型语言模型,如训练gpt-3(1750亿参数)这样的大语言模型速度比tpu v4快2.8倍。

不过,这种更高的性能和可扩展性也是有代价的。每个tpu v5p加速器的运行费用为每小时4.2美元,而tpu v4加速器为每小时3.22美元,tpu v5e加速器每小时1.2美元。

谷歌tpu芯片训练大模型的参数比较。

“在我们的早期使用阶段,谷歌deepmind和谷歌research观察到,与我们的tpu v4芯片相比,使用tpu v5p芯片的大语言模型(llm)训练工作负载的速度提高了两倍。”谷歌deepmind首席科学家杰夫·迪恩(jeff dean)写道,“对机器学习框架(jax、pytorch、tensorflow)和编排工具的强大支持使我们能够在v5p上更高效地扩展。通过第二代sparsecores,我们还看到嵌入密集型工作负载的性能有了显着提高。tpu对于我们在gemini等尖端模型上进行最大规模的研究和工程工作至关重要。”

除了新硬件之外,谷歌还引入了“人工智能超级计算机”的概念。谷歌云将其描述为一种超级计算架构,包括一个集成系统,具有开放软件、性能优化硬件、机器学习框架和灵活的消费模型。

谷歌计算和机器学习基础设施部门副总裁马克·洛迈尔(mark lohmeyer)在博客文章中解释道,“传统方法通常通过零碎的组件级增强来解决要求苛刻的人工智能工作负载,这可能会导致效率低下和瓶颈。”“相比之下,人工智能超级计算机采用系统级协同设计来提高人工智能训练、调整和服务的效率和生产力。”这可以理解为,与单独看待每个部分相比,这种合并将提高生产力和效率。换句话说,超级计算机是一个系统,其中任何可能导致性能低下的变量(硬件或软件)都受到控制和优化。

(原标题:)

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负yabo亚博88的版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。